Zero-shot Learningの論文

- Pedro Morgado Nuno Vasconcelos, Semantically Consistent Regularization for Zero-Shot Recognition

https://arxiv.org/pdf/1704.03039.pdf

word2vec embeddingを用いて、補助情報(auxiliary information)であるテキストアノテーションの意味的(semantics)特徴量を抽出する。

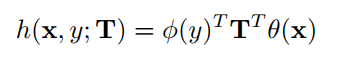

一般的な、以下のcompatibility functionを学習する。ここで、はCNN特徴量で、\phi(y)はword2vec特徴量である。

このCNN特徴量とword2vec特徴量との内積による、compatibility functionを用いることにより、学習時にunseenだったデータに対しても、分類することができる。

つまり、compatibilityスコアが高いyに分類する。

本論文では、以下のようにend2endでCNN特徴量も学習している。

具体的には、以下の2つを提案し、比較している。前者のDeep RISは、CNNのパラメータの更新を行わないので、独立と言っている。

一方、Deep RULEは、CNNのパラメータを、全体のsoftmax loss(尤度最大化)に基づいて更新しているところが異なる。

Deep RIS: Deep recognition using independent semantics

Deep RULE: Deep recognition using semantic embeddings

さらに、学習時に制約を入れるところで工夫しているとのこと。

- Yuchen Guo et al., Transductive Zero-Shot Recognition via Shared Model Space Learning

https://www.aaai.org/ocs/index.php/AAAI/AAAI16/paper/download/11975/12120

Transductiveの設定(つまり、ラベルなしのテストデータが与えられている)におけるZero-Shot Learningの論文。

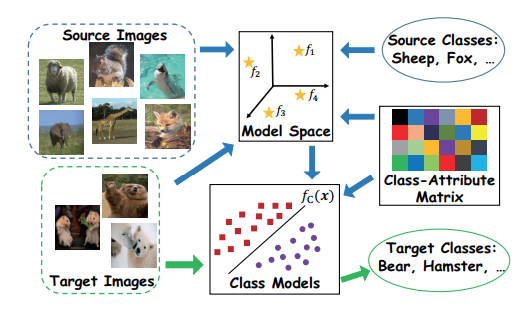

一般的な、attribute-based Zero-shot recognitionでは、

学習データ(source)には、各画像に対してattribute(黒い、水などの属性ラベル)が与えらている条件のもと、画像から各attributeを予測するモデルを学習する。

さらに、各クラスとattributeの関係を表す行列(class-attribute matrix)を求める。

そして、テスト画像(target)のattributeを予測する。テスト画像のattributeと、未知のクラス(attributeが与えられているという条件のもと?)のattributeを比較し、分類する。

つまり、attributeという間接的な情報を介して分類「image => attribute => class」をする方法である。

Pedro Morgadoの方法におけるクラスのyのword2vecをattributeとみなせば、zero-shot learningのタスクって「image => attribute => class」を予測するモデルを学習することなのか?

これに対して、Transductiveの設定では、教師なしデータが与えられているので、半教師学習の要素が加わる。通常の設定では、sourceおよびtarget共通の固定のCNNを用いて特徴抽出をしていた。

半教師学習の設定では、targetのラベルなし画像データを用いられるので、targetのデータを、スムーズな制約などに用いて、CNNを学習しなおし、共通の特徴空間(model space)をつくる。

- Georgiana Dinu et al., IMPROVING ZERO-SHOT LEARNING BY MITIGATING THE HUBNESS PROBLEM, ICLR2015

https://arxiv.org/pdf/1412.6568.pdf

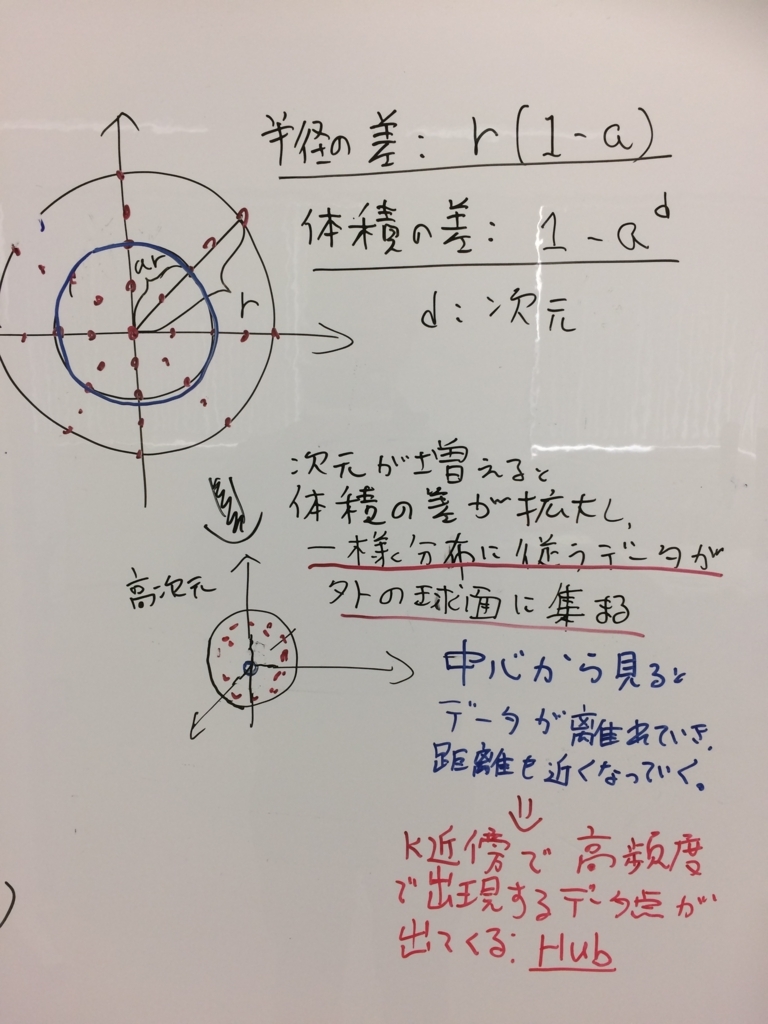

高次元空間で起こるHubness problemは、Zero-shot learningにてよくsemantics spaceとして用いているword vectorにてもよく起こるらしく、zero-shot learningにて悪さするとのこと。

http://www.ism.ac.jp/~fukumizu/CoopMathWS2014/Radovanovic-HubsInNNGraphs.ppt

Hubness problemとは、高次元空間におけるk-nearest neighborにて、本来は近くないのに、多くのデータ点からのk近傍に入るデータ点(Hub)が出現でてきて、精度を低下させる問題である。これは、球面集中現象(concentration)によるものらしい(http://ibisforest.org/index.php?球面集中現象)。

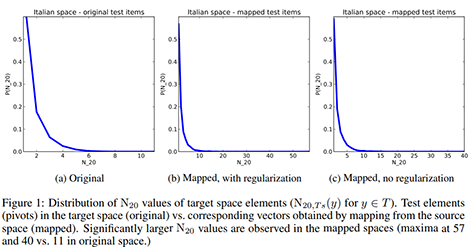

このhubness問題が、zeroshot learningのsemantics spaceにて、以下のように顕著に起きているとのこと。つまり、original spaceでは、N20(20近傍に入った回数が横軸)が最大で11だったのに対し、mapped spaceではN20の最大は54まで増加している。regularizationをかけている場合でも。

- Ubai Sandouk and Ke Chen, Multi-Label Zero-Shot Learning via Concept Embedding

Zero-Shot Learningをマルチラベルに拡張

https://arxiv.org/ftp/arxiv/papers/1606/1606.00282.pdf